Makina Blog

SEO : introduction technique au référencement

Le référencement (ou Search Engine Optimization) est un (très) vaste sujet. Voici une introduction à sa partie technique.

Cet article concerne essentiellement Google, le marché français étant actuellement ultra-dominé par ce moteur (+ 90% des visites organiques).

Avertissement : la plupart des liens de cet article mènent vers des sites en anglais, base de connaissance plus large que les articles français (et étape nécessaire pour des articles très fouillés sur certains sujets). Néanmoins, quand un équivalent français existait, il est indiqué en priorité.

Que veut Google ?

Afficher la réponse la plus pertinente possible pour une requête donnée, c'est un moteur de réponses plus qu'un moteur de recherche.

Quelques définitions

Le crawl et l'indexation sont 2 notions distinctes et pourtant confondues par de nombreux développeurs ne connaissant pas trop le domaine du référencement.

Le crawl

Le crawl est le processus par lequel les robots des moteurs parcourent un site, lisant le code des pages. Grossièrement, c'est comme si vous faisiez "afficher la source" de chacune des pages de votre site, et que vous suiviez ensuite chaque lien de la page. Les pages parcourues par les robots sont normalement contrôlables par le fichier robots.txt à la racine de votre site.

Fastidieux à reproduire à la main, il existe de nombreux outils pour vous permettre d'automatiser cette étape : grâce à sa disponibilité sous Linux, j'utilise Screaming Frog, mais BeamUsUp est également disponible, et je vous recommande également le crawler en ligne Botify (et OnCrawl commence à faire parler de lui en France). Vous découvrirez ainsi comment les moteurs perçoivent techniquement votre site et vous lèverez un certain nombre de problèmes associés à la partie "technique" ci-dessous. Au passage, vous constaterez que pour s'assurer de la façon dont Google perçoit votre site, de nombreux outils font de l'analyse de logs plutôt que du crawl standard.

Attention : les moteurs allouent souvent un temps fixe au parcours de votre site, d'où l'importance de la performance, pour que votre site soit parcouru plus en profondeur lors du passage du robot (voir Crawl Optimization pour les détails de cette affirmation).

L'indexation

L'indexation est simplement le fait qu'une page apparaisse dans l'index des moteurs. On peut "contrôler" cette indexation par le META Robots, qui peut prendre par exemple la valeur "NOINDEX" pour demander aux moteurs de ne pas afficher cette page dans leurs résultats de recherche.

La différence

Tout est possible en référencement : crawler une page et ne pas l'indexer (META ROBOTS NOINDEX), mais aussi ne pas crawler une page (bloquée par le fichier robots.txt) et pourtant l'indexer, parce que par exemple de nombreux liens externes pointent vers cette page. Vous devrez alors retirer cette page du robots.txt et mettre un META ROBOTS NOINDEX pour que le robot parcourt votre page, et la désindexe.

Les bases du référencement

Les bases du SEO sont souvent présentées sous forme de pyramide (tapez pyramide SEO dans Google Images, vous ne serez pas déçus), mais pas toujours dans le même ordre, c'est pourquoi je vais simplement parler de plusieurs pôles sur lesquels se concentrer : la technique, le contenu, et la popularité (ou les liens).

La technique

La technique est ce qui permettra aux moteurs de recherche de bien comprendre votre contenu. Entièrement basée sur le langage HTML, certaines balises permettront à votre site de donner des informations spécifiques aux moteurs de recherche, mais également aux réseaux sociaux, à propos d'une page de votre site.

Par exemple, la balise "TITLE" dans le "HEAD" de l'HTML représente le texte principal (celui qui contient le lien) affiché dans les moteurs de recherche en réponse à une demande effectuée. C'est également le texte qui apparaît souvent dans la barre d'en-tête de votre navigateur (ou de l'onglet courant). C'est souvent la même chose que le titre principal de la page (balise H1), mais rien ne l'oblige.

La balise META "Description" représente le texte affiché ensuite dans les résultats de recherche (les fameux "SERP" : "Search Engine Result Pages").

Pour voir à quoi ressemble une page de votre site dans les résultats de recherche, il vous suffit de taper "site:votre-url" dans Google.

Les balises META

Il existe de très nombreuses balises META. J'ai déjà parlé ci-dessus des plus courantes (Description, Robots), mais il en existe beaucoup d'autres, certaines spécifiques à des moteurs, d'autres à des réseaux sociaux.

Par exemple, les balises META "twitter:card" permettent à Twitter d'afficher des informations supplémentaires sur un tweet donné. Je vous invite à consulter la documentation officielle pour aller plus loin : dev.twitter.com/cards.

Facebook et Google+ utilisent de leur côté les META OpenGraph, commençant par og (comme OpenGraph). Au passage, sachez que vous pouvez rafraîchir le cache de Facebook sur une page de votre site en utilisant la page open graph debugger.

On constate ici que derrière le terme "générique" SEO se situent en réalité de nombreuses techniques pour augmenter le nombre de visiteurs de votre site, parfois même sans lien avec les moteurs de recherche (on parle alors parfois de Social Media Optimisation). Comme tout tourne autour de la présentation de votre contenu pour des robots, ces domaines sont cependant liés.

Le contenu dupliqué et la balise CANONICAL

Il existe des cas où vous n'arriverez pas à empêcher la duplication de contenu sur votre site. Dans ce cas, la recommandation de Google est d'utiliser une balise Canonical indiquant à Google la "principale" version du contenu courant. Vous trouverez sur https://en.onpage.org/blog/canonical-guide-dos-and-donts un résumé de ce qu'il faut faire ou non avec cette balise.

Attention, tout ceci ne constitue qu'une indication pour les moteurs qui traitent la balise comme ils l'entendent (comme souvent en référencement).

Le fichier sitemap.xml

On trouve fréquemment à la racine du site un (ou plusieurs) fichier(s) sitemap.xml dont la fonction est de lister les pages de votre site pour guider le crawl des moteurs. Là encore, ce fichier ne constitue qu'une indication et les moteurs en font ce qu'ils veulent.

De manière générale, je partage les conclusions de cet article et considère que pour un "petit" site (moins de 10 000 pages), ce fichier est inutile et les robots sont plus efficaces, sous réserve que votre site soit correctement conçu en terme d''arborescence. Au-delà, le fichier peut apporter une plus-value en ciblant le travail du robot.

Enfin, les fichiers sitemap peuvent également avoir une utilité en différenciant les contenus qu'ils contiennent (un pour les news, un pour les vidéos, …).

La performance

La performance est importante pour le moteur de recherche (optimisation du crawl), mais également tout simplement pour les visiteurs de votre site (qui reviendront plus naturellement si ils ne doivent pas trop attendre chaque chargement de page). Il serait trop long et impossible de couvrir l'ensemble des points liés à la performance d'un site (de plus, le sujet est très technique), donc reportez-vous à nos articles sur le sujet pour identifier des points à travailler ou demandez-nous un audit de performance si besoin.

Le contenu

"Following best practices often does nothing for new and emerging sites." (Rand Fishkin dans 5 seo problems)

Si vous suivez toutes les bonnes pratiques décrites dans la section précédente, vous aurez un site correctement compris par les moteurs de recherche. Ces bonnes pratiques sont respectées par la plupart des CMS aujourd'hui, notamment Drupal et Plone que nous utilisons au quotidien.

Cependant, sans contenu intéressant, votre site ne sera pas forcément positionné dans les premières positions des moteurs (à moins d'être sur un secteur pas du tout concurrentiel ou un site propre suffira). En effet, c'est l'intérêt de votre contenu qui fera (re)venir les visiteurs et suscitera des liens externes de qualité vers votre site, et donc des possibilités d'être correctement positionné.

En plus de la qualité du contenu, l'organisation de ce contenu dans le site a également son importance : vous pouvez "pousser" certaines pages de votre site en adoptant des structures hiérarchiques de site adaptées. Une structure interne dont on parle beaucoup ces temps-ci est le cocon sémantique, évolution du concept de silo.

Sans aller plus loin dans la partie "contenu" de votre site (qui relève plus du marketing et pour lequel je ne suis pas spécialiste), la consistance dans le choix des mots-clés utilisés dans votre texte est un premier pas pour augmenter vos chances de référencement sur un terme, mais aujourd'hui on joue également sur des proximités sémantiques, et l'écriture de contenu devient une vraie science.

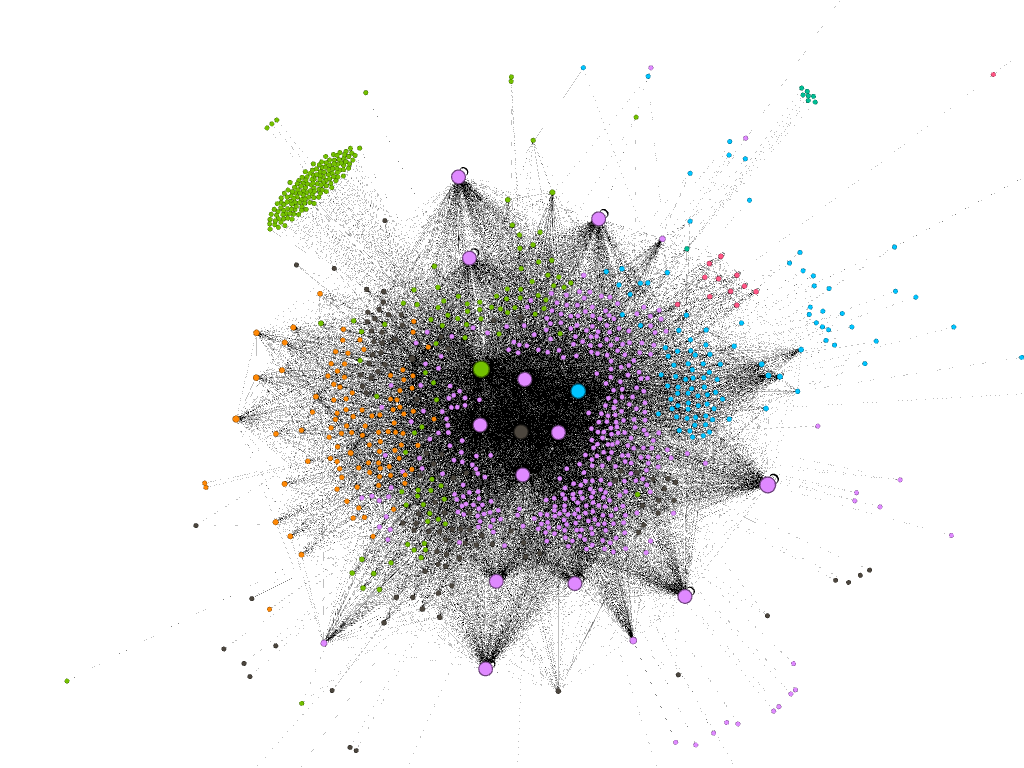

D'un point de vue plus technique, si vous cherchez comment calculer le PageRank interne de vos pages, l'algorithme est public : http://www.canyouseome.com/comment-calculer-le-page-rank/, et est par exemple implémenté sur le logiciel open source Gephi (ci-dessous un exemple de visualisation de site web, la taille du point étant proportionnelle au Page Rank).

Il existe également des outils d'analyse pour évaluer sur quels mots clés vous êtes positionnés : alyze, semrush, … Tout ceci vous aidera, mais rien ne remplace un contenu de qualité (à la fois pour les moteurs de recherche, mais surtout pour vos visiteurs ;-)).

La popularité

Là, pas de secret, il faut des liens (et des bons). Cela demande là aussi beaucoup de travail, les domaines qui font des liens vers votre site ont des critères de confiance par les moteurs qui font que tous les liens ne se valent pas. Mais sans popularité de vos contenus, peu de chances de briller là aussi. Il y aurait ici également beaucoup à dire également, mais l'on sort des critères purement techniques et je n'irai donc pas plus loin (et là encore, la qualité du contenu est primordiale).

Plusieurs types de réponses

80% des clics sont occasionnés sur les 3 premiers liens renvoyés par Google : plus ou moins 60% sur le premier, 15% sur le deuxième, et cela descend rapidement ensuite (d'où l'importance d'être dans les tous premiers résultats).

Mais selon les requêtes, Google renvoie différents types de réponses, incluant parfois des vidéos, des diaporamas, une carte. Il est donc possible de se positionner autrement que sur les 3 premiers résultats "classiques".

Le référencement "local"

Par exemple, pour travailler son positionnement "local" : http://www.slideshare.net/aleydasolis/making-the-most-out-of-your-local-seo-at-seocamp-paris ou http://www.whitespark.ca/blog/post/62-the-json-ld-markup-guide-to-local-business-schema.

Le référencement "mobile"

Il est possible de référencer son application, permettant aux moteur de recherche sur votre appareil mobile de faire des liens directement du moteur vers une application installée sur votre mobile. Vous pourrez en apprendre plus ces liens : https://moz.com/blog/how-to-get-your-app-content-indexed-by-google et http://thenextweb.com/opinion/2015/06/14/app-indexing-will-fix-app-search-but-google-and-apple-are-using-it-differently/.

Le référencement international

De même, un site international doit se référencer de manière spécifique, pour faire correspondre les pages des différents langages entre elles. Vous trouverez les informations de base sur http://searchengineland.com/5-questions-select-right-structure-international-websites-233301.

Le référencement "News"

Pour la presse en ligne, notamment, mais pas que, de la même manière, on pourra travailler spécifiquement sur le référencement Google News (voir à cet effet les présentations de @largow).

Et le reste

Vous pouvez également travailler votre référencement LinkedIn, Youtube, Pinterest … bref, il y a plein de manières de travailler sa visibilité.

L'e-commerce

Enfin, l'e-commerce rencontre également des problématiques spécifiques : http://www.slideshare.net/audette/seo-for-ecommerce-a-comprehensive-guide. On trouve également un très long article de Moz sur comment améliorer le référencement de son site e-commerce.

Le coin de la technique

Quelques algorithmes impliqués

Pour les intéressés, Laurent Bourelly, lors de la récente conférence BlendWebMix, a cité selon lui les 3 principaux algorithmes à connaître, tous impliqués dans l'analyse sémantique d'un texte :

La sémantique, c'est quoi ?

En plus de l'analyse sémantique d'un texte (et donc de la proximité des corpus de termes), il existe un domaine "sémantique" au niveau du balisage des pages (qui n'a rien à voir avec l'autre "sémantique") : il est en effet possible d'insérer dans le code de vos pages un balisage spécifique permettant de communiquer aux moteurs (ou à d'autres analyseurs de pages) des informations complémentaires (horaires, revues), …qu'ils pourront décider d'afficher ou non.

Là, encore, vous trouverez un guide complet sur https://builtvisible.com/micro-data-schema-org-guide-generating-rich-snippets/.

Par exemple, une utilisation de la sémantique pour afficher directement dans les résultats du moteur de recherche les dates de nos formations :

Si ces informations sémantiques ne contribuent pas forcément à vous placer en meilleure position que d'autres, c'est en tout cas des informations supplémentaires pour les visiteurs, et donc potentiellement un meilleur taux de clic sur le résultat de recherche, par exemple.

Cela permet également éventuellement à des moteurs spécialisés sur un domaine d'agréger vos informations, et donc pour votre site d'apparaître sur plus de moteurs, surtout des moteurs dédiés à un domaine.

Pour tester l'utilisation de sémantique sur vos pages, Google fournit un outil adapté.

Et le Javascript dans tout ça ?

Pendant longtemps, Google n'indexait pas les sites contenant du javascript, et il fallait fournir une version HTML alternative pour les application qui voulaient se voir indexer. Cela a changé en 2015. Et Google comprend désormais (un peu) le javascript. A suivre de près, cela risque d'évoluer énormément dans les mois / années à venir.

Les outils

Il existe aujourd'hui de nombreux outils permettant de vous assister dans votre compréhension de votre site et de vos visiteurs, pour mettre au point une stratégie de référencement ou son suivi.

Google Analytics

Google Analytics n'est que marginalement utile au référencement pur, mais prend plus d'importance dès qu'on touche au marketing du site, consultez Connaître l'efficacité d'un site pour la configuration de base. La frontière entre le référencement et le marketing étant plus floue de jour en jour, la connaissance de cet outil vous aidera également.

Search Console

Search Console est le nouveau nom des Webmaster Tools de Google, cela vous permet d'observer l'évolution de votre présence sur Google ainsi que les mots-clés utilisés pour vous trouver. Il existe de la même façon les "Bing Webmaster Tools".

Les crawlers

J'ai déjà parlé dans la section du crawl, mais un outil d'analyse de votre site est indispensable pour vous aider dans votre analyse de votre site.

Les audits

La première étape pour améliorer le référencement d'un site est souvent d'en réaliser un audit. http://www.webgnomes.org/blog/grantland-seo-audit-example/ en présente un exemple détaillé, même si c'est un domaine qui évolue tout le temps et que cet exemple commence à dater un peu.

Vous pouvez consulter également des articles sur un audit technique (ou en français avec audit SEO SMX) ou un audit plus ciblé référencement "local".

Tous ces articles reprennent les choses que nous vérifions lors de notre audit.

Les pièges classiques

Refonte de site

La principale problématique lors d'une refonte de site est de récupérer le "jus" de vos anciennes pages. Il est donc primordial de planifier les redirections des anciennes pages vers les nouvelles (et PAS de s'en préoccuper une fois le nouveau site mis en ligne, comme c'est encore trop souvent le cas). Voici un bon article pour vous aider.

Le multilinguisme

La balise hreflang peut facilement être mal utilisée : http://searchengineland.com/auditing-hreflang-annotations-common-issues-avoid-219483.

D'autres pièges selon le type de site

Botify a publié un article référençant les principaux problèmes selon votre type de site (éditorial, e-commerce, …) : https://www.botify.com/blog/top-seo-pitfalls-by-type-of-website/.

Résolution de problèmes

Pourquoi mon trafic baisse

Quand on fait du référencement, la hantise est la baisse de trafic d'un site. Or, elle peut avoir plusieurs causes, certaines conjoncturelles (baisse saisonnière), d'autres techniques. Plutôt que de tout détailler, je vous renvoie à cette checklist (en français).

Pénalités Google

Une autre crainte répandue concerne les pénalités (automatiques ou manuelles) infligées par Google et ses algorithmes (Panda, Pinguin, Hummingbird, …). Voici donc quelques informations à leur sujet :

- D'abord, la référence pour comprendre les gros changements sur les graphiques renvoyés par GoogleAnalytics ou la Search Console, les dates de mise en place des algorithmes : http://moz.com/google-algorithm-change ;

- Leur "définition", ou la raison de leur mise en place : https://en.pedrodias.net/google/google-penalties ;

- Un article plus spécifique sur Panda : http://www.thesempost.com/understanding-google-panda-definitive-algo-guide-for-seos/ ;

- Enfin, un article détaillé sur comment réagir à leur encontre : http://www.goinflow.com/the-marketing-executives-guide-to-google-algorithm-updates-seo-risk/.

Conclusion

Tout ce que j'ai raconté dans cet article sont des "bonnes pratiques", ou même des recommandations de Google. À vous maintenant de les mettre en place, mais n'oubliez pas que le référencement bouge souvent parce que les référenceurs valident ces bonnes pratiques, à force de discussions, de tests (10 SEO experiments that will change the way you do SEO), d'hypothèses validées ou non. Ne croyez pas tout sur parole, pratiquez, essayez. Échouer est la première étape de l'apprentissage.

Retenez également que le SEO, ce n'est surtout pas que de la technique. Tout ce qui favorise une bonne expérience utilisateur sur votre site (qualité de l'architecture, performance, accessibilité, …) servira globalement votre référencement, alors faites de la qualité, vous ne le regretterez pas !

L'image en exergue au début de l'article provient de Wikimedia Commons.

Formations associées

Formation Matomo

Formation Matomo : migration Google Analytics vers Matomo

Toulouse ou distanciel A la demande

Voir la Formation Matomo : migration Google Analytics vers MatomoActualités en lien

Calculez sur GPU avec Python – Partie 3/3

Data Science

20/02/2025

Calculez sur GPU avec Python – Partie 2/3

Data Science

11/02/2025

Calculez sur GPU avec Python – Partie 1/3

Data Science

04/02/2025